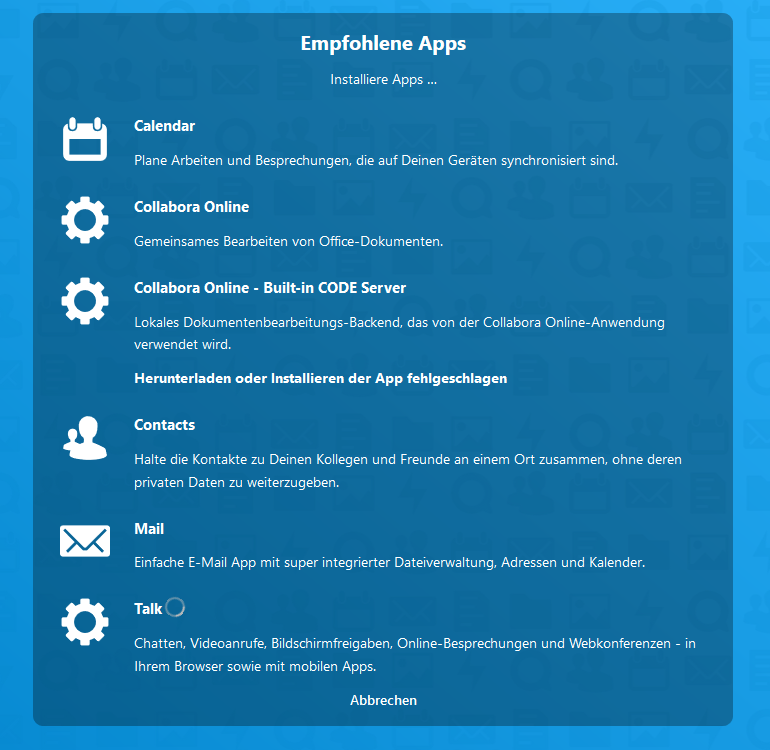

Ich habe die Entscheidung mehrere Wochen aufgeschoben. Fakt ist, daß ich meine Nextcloud in letzter Zeit nicht sehr häufig benutzt habe. Für Card,-CalDAV nutze ich die Synology-Eigenen Dienste, die Nutzerdaten liegen auch auf der Synology. Warum also nicht auf ein System – welches gewartet und gepflegt werden will – verzichten. Am Anfang war das ja ganz neu, toll und ambitioniert. Ich habe mir extra nochmal die Mühe gemacht, die jüngste Version 20.0.1 auf einem Debian 10.6 frisch zu installieren. Spaßeshalber habe ich mal die “Empfohlenen Apps” mitinstallieren lassen. Die Installation des “Collabora online – built-in Code server” hat nicht geklappt. Es hätte mich wirklich überrascht wenn alles auf Anhieb funktioniert hätte.

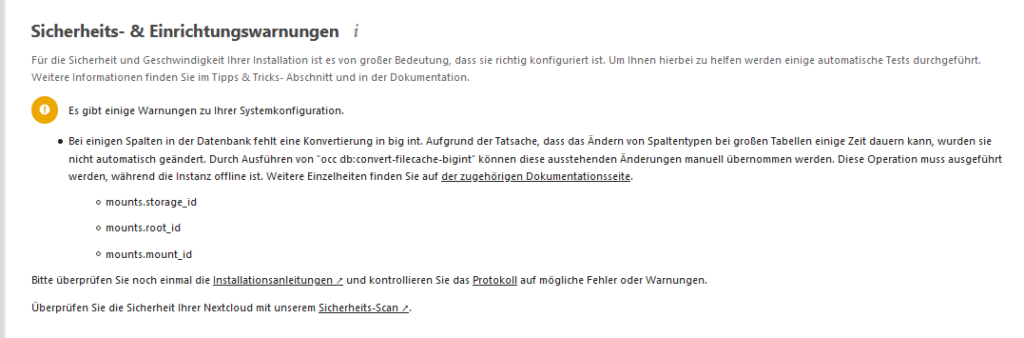

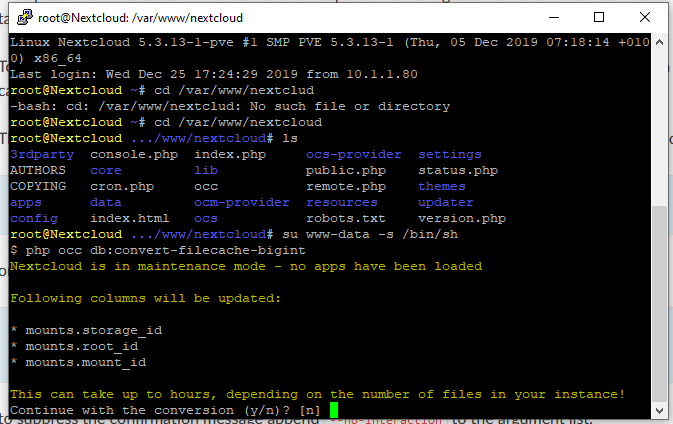

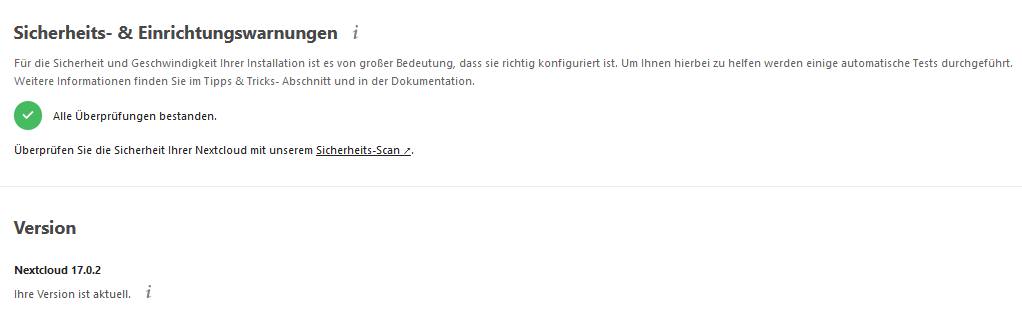

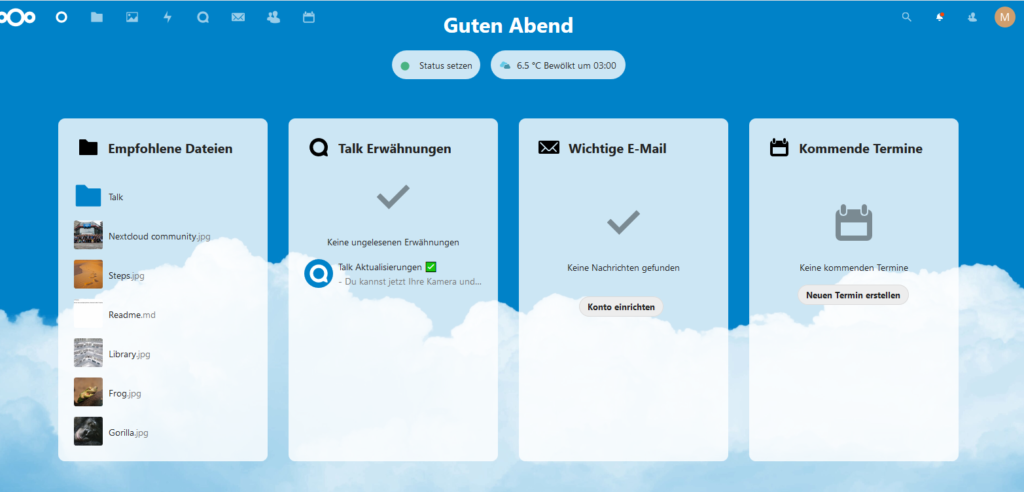

Überdrüssig bin ich auch der Beseitungen der ganzen Einrichtungswarnungen nach der Installation bzgl. Cache, Uploadlimit, SSL und so weiter gewesen. Mein Nutzerverhalten hat sich nicht großartig geändert, aber die Erwartungen an einen Dienst. Ich erwarte keine “One-Click”-Einrichtung aber unter “Benutzerfreundlich” verstehe ich was anderes. Vermutlich bin aber ich auch nicht die anvisierte Zielgruppe und das ist auch völlig in Ordnung. Positiv angetan war ich von dem neuen Dashboard welches so richtig gut und modern aussieht. Die Ernüchterung kam dann aber wieder bei den Standardsachen wie Files und Kalender. Sieht immer noch genauso alt aus.

Ich finde Nextcloud hat sich seiner ursprünglichen Intention etwas abgewandt. Es setzt meines Erachtens zu sehr auf Quantität als auf Qualität. Meine Ansicht deckt sich ein wenig mit Karsten, welcher in seinem Blog zu Nextcloud treffend schrieb:

“Es zieht sich schon länger durch meinen Blog, aber ich will es doch noch einmal schreiben: die zunehmende Funktionsvielfalt halte ich für ein Problem. Ich denke nicht, dass ich die nunmehr integrierte Bearbeitungsfunktion von Officedokumenten tatsächlich nutzen werde. Das erledigen lokale Installationen besser (und schneller!). Interessant wohl ohnehin nur für Firmen und entsprechend große Umgebungen …“

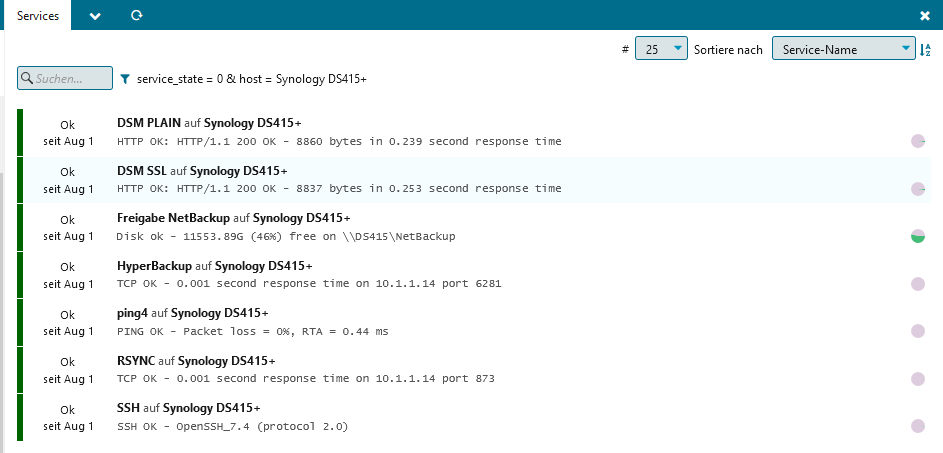

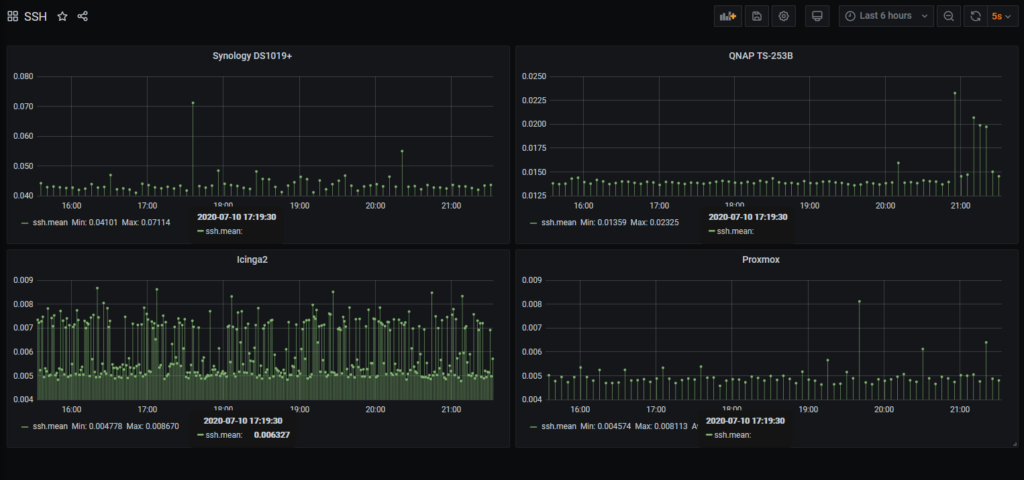

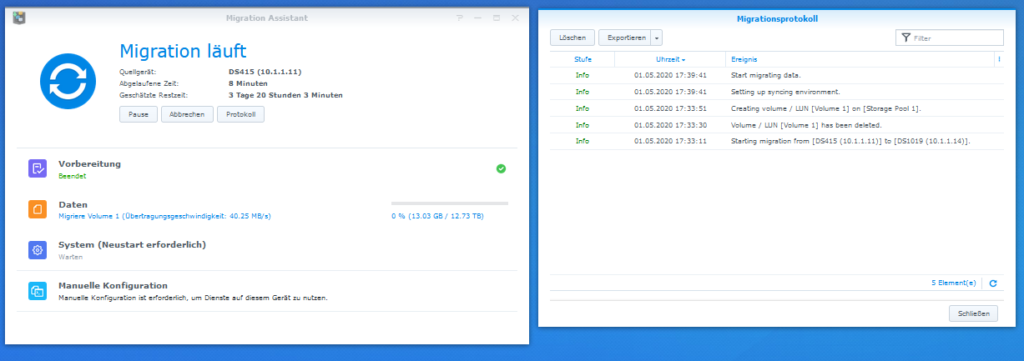

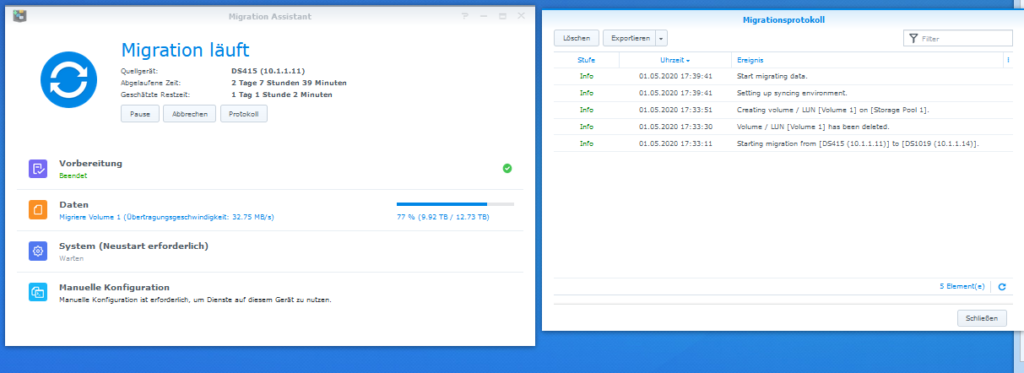

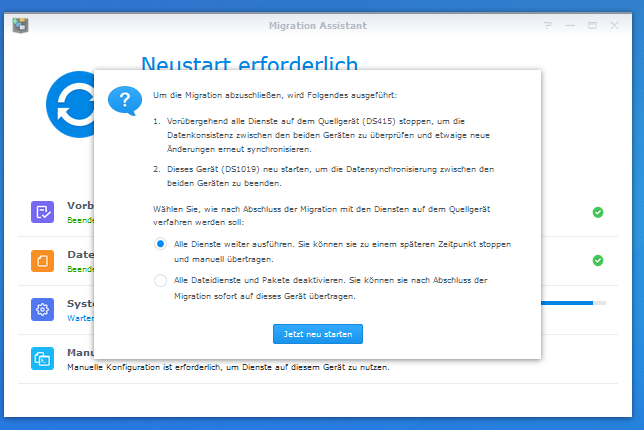

Ich werde das Projekt weiterverfolgen, evtl. mal die ein oder andere Installation mitmachen aber für produktive Sachen nehme ich zukünftig überwiegend die Dienste meiner Synology in Anspruch.